ECCV2018採択論文"Value-aware Quantization for Training and Inference of Neural Networks"の解説.

Abstract

ニューラルネットワークの量子化手法であるV-Quantの提案. ネットワークの重みで用いられる値のprecisionを削減することでモデルの高速化を達成することを目的としている.

Contribution

- 本論文では,ニューラルネットワークの重みの値の分布は大部分が一定のレンジに収まり,ごく少数の大きな値が広い領域に分布しているという観測に基づいて,新しい量子化の手法を提案している.

- この観測に基づいて,提案手法では,大多数の値が分布するレンジでは精度を落とし,少数の大きな値は高精度で処理することで量子化による誤差の削減を目指している.

Proposed Method

Fig. 1の(a)と(b)はGoogLeNetの2つめの畳み込みレイヤーのweightsとactivationsの分布を図示したものである.図に示されている通り,どちらも少数の大きな値によって分布の裾が広がっていることがわかる.一般的に,分布が広がれば広がるほど,精度を落として処理した際の量子化誤差は大きくなる.

Fig. 1の(c)はFig. 1の(a)を3-bit量子化したものである.図の通り,分布が広いせいで,量子化レベルの間隔が広く取られてしまっている.Fig. 1の(a)と(c)を比べてみると,量子化結果は元のデータの大部分をうまく捉えることができていないことがわかる.

これを受けて,Fig. 1の(d)は本論文の提案するアイディアを示している.提案手法では,全てのデータに対して量子化を行うのではなく,大部分のデータが属する小さな値にのみ量子化を行い,高い値をとる少数のデータに対しては高精度で処理する.これは,一般的に大きな重みの値は,ニューラルネットワークの出力により大きな影響を及ぼすはずという観測に基づく.

提案手法は以下の流れに沿って適用される. 1. ネットワークの学習時および推論時に発生する大きな値を特定する 2. 少数の高い値については高精度を保ちながら,大多数の小さな値に対して量子化を適用する

この論文における提案手法をvalue-aware quantization (V-Quant)と呼ぶ.

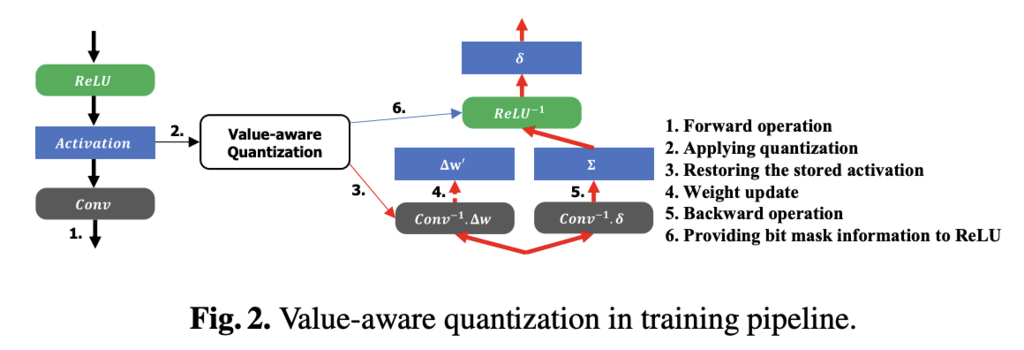

Fig. 2に提案手法をどのように既存の学習パイプラインに適用するのかを示す.

Experimental Results

Table 1はResNet-50に対して,複数のbitwidthの元でV-Quantを適用した際の実験結果を示している.

Table 1. Top-1/top-5 accuracy [%] of ResNet-50 with various bitwidth & AR configurations. The full-precision network gives the accuracy of 75.92/92.90%. Fig. 5はAlexNetの出力層の直前のactivationsをPCAで可視化した結果を示している.単純な線形量子化を適用した場合と比べて,提案手法を用いることで分布をうまく捉えることができていることがわかる.

Conclusion

ECCV2018採択論文"Value-aware Quantization for Training and Inference of Neural Networks"の解説を行った.アイディアとしては単純で,分布の多くを占めるレンジのみに量子化を適用することで,ネットワークの分類性能の低下を避けながらモデルの軽量化および高速化を目指している.

References

- Park, Eunhyeok, Yoo, Sungjoo, and Vajda, Peter. Value-aware quantization for training and inference of neuralnet works. In The European Conference on ComputerVision (ECCV), September 2018.